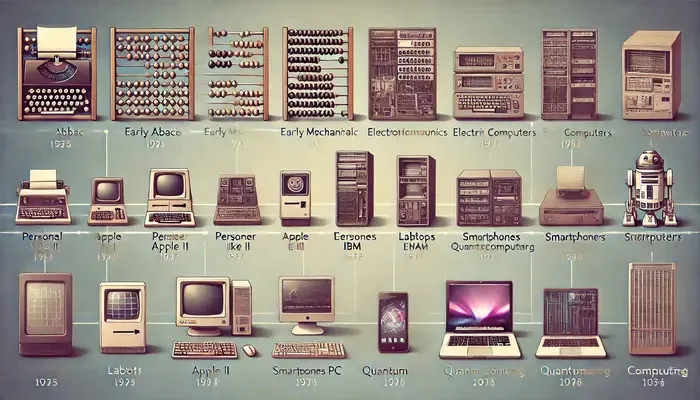

Evoluzione della tecnologia informatica

L’evoluzione della tecnologia informatica è stata un viaggio segnato da traguardi notevoli e scoperte tecnologiche. Dalla nascita dei dispositivi informatici meccanici all’avvento dell’informatica quantistica, questa evoluzione ha trasformato il modo in cui viviamo, lavoriamo e interagiamo con il mondo. Questo articolo approfondisce le tappe significative di questa evoluzione, evidenziandone gli sviluppi principali e i loro impatti.

Primi passi: dispositivi informatici meccanici

Il viaggio della tecnologia informatica è iniziato con dispositivi meccanici progettati per eseguire semplici operazioni aritmetiche. Uno dei primi strumenti conosciuti è l’abaco, utilizzato per secoli come ausilio nei calcoli. Nel XVII secolo Blaise Pascal inventò la Pascalina, una calcolatrice meccanica capace di addizioni e sottrazioni. Più tardi, nel 19° secolo, Charles Babbage concettualizzò la macchina analitica, un dispositivo più sofisticato che gettò le basi per i computer moderni. Sebbene non sia mai stato completato in vita sua, il progetto di Babbage prevedeva componenti come un’unità di controllo e una memoria, fondamentali per i computer di oggi.

Macchine informatiche elettroniche (ECM)

L’alba del 20° secolo ha visto il passaggio dai calcolatori meccanici a quelli elettronici. Lo sviluppo del tubo a vuoto fu un momento cruciale, che portò alla creazione dei primi computer elettronici negli anni ’40. ENIAC (Electronic Numerical Integrator and Computer), sviluppato nel 1945, è stato uno dei primi computer digitali elettronici per scopi generali. Era in grado di eseguire calcoli complessi a velocità senza precedenti. Quest’epoca vide anche l’introduzione del codice binario, che divenne il fondamento di tutte le successive operazioni informatiche.

Sviluppo di personal computer

Gli anni ’70 segnarono un cambiamento significativo con lo sviluppo dei personal computer (PC). Aziende come Apple e IBM hanno rivoluzionato l’informatica rendendola accessibile al grande pubblico. L’Apple II, lanciato nel 1977, e il PC IBM, introdotto nel 1981, divennero nomi familiari. Queste macchine erano alimentate da microprocessori, che riducevano drasticamente le dimensioni e il costo dei computer aumentandone la potenza e l’efficienza. Lo sviluppo di sistemi operativi di facile utilizzo, come MS-DOS di Microsoft e successivamente Windows, ha ulteriormente accelerato l’adozione dei PC.

L’emergere di laptop e computer portatili

Con l’avanzare della tecnologia, il desiderio di portabilità ha portato allo sviluppo di laptop e computer portatili. Il primo laptop di successo commerciale, l’Osborne 1, fu rilasciato nel 1981, sebbene fosse ingombrante per gli standard odierni. Nel corso degli anni, i laptop sono diventati più compatti e potenti, con innovazioni come il touchpad e la connettività wireless che ne hanno migliorato l’usabilità. Gli anni 2000 hanno visto l’ascesa di smartphone e tablet, unendo la potenza di calcolo alla mobilità e rivoluzionando il modo in cui accediamo e interagiamo con le informazioni in movimento.

Internet e il suo impatto sull’informatica

L’avvento di Internet alla fine del XX secolo ha trasformato radicalmente l’informatica. Inizialmente sviluppata come rete per uso accademico e militare, Internet si è rapidamente espansa fino a diventare una piattaforma di comunicazione globale. La creazione del World Wide Web da parte di Tim Berners-Lee nel 1989 ha consentito un facile accesso alle informazioni e lo sviluppo dell’e-commerce, dei social media e dei servizi online. Internet ha inoltre stimolato la crescita del cloud computing, consentendo l’archiviazione e l’elaborazione dei dati su server remoti, che è diventato parte integrante dell’informatica moderna.

Sviluppo di software

Oltre ai progressi dell’hardware, lo sviluppo del software ha svolto un ruolo cruciale nell’evoluzione della tecnologia informatica. I primi software erano spesso scritti su misura per macchine specifiche. Tuttavia, lo sviluppo di linguaggi di programmazione come Fortran, COBOL e successivamente C e Java, hanno standardizzato lo sviluppo del software. L’ascesa del software open source, come Linux, ha favorito la collaborazione e l’innovazione. Il software moderno spazia dai sistemi operativi e dagli strumenti di produttività alle complesse applicazioni per l’intelligenza artificiale e l’analisi dei dati, portando le capacità dell’hardware a nuovi livelli.

Supercomputer e informatica quantistica

La ricerca di una maggiore potenza computazionale ha portato allo sviluppo dei supercomputer e, più recentemente, all’informatica quantistica. I supercomputer, come quelli sviluppati da Cray negli anni ’70, vengono utilizzati per simulazioni e calcoli complessi in campi come la scienza del clima e la biologia molecolare. L’informatica quantistica, ancora nelle sue fasi nascenti, promette di rivoluzionare l’informatica sfruttando i principi della meccanica quantistica. I computer quantistici hanno il potenziale per risolvere problemi attualmente intrattabili per i computer classici, aprendo nuove frontiere nella scienza e nella tecnologia.