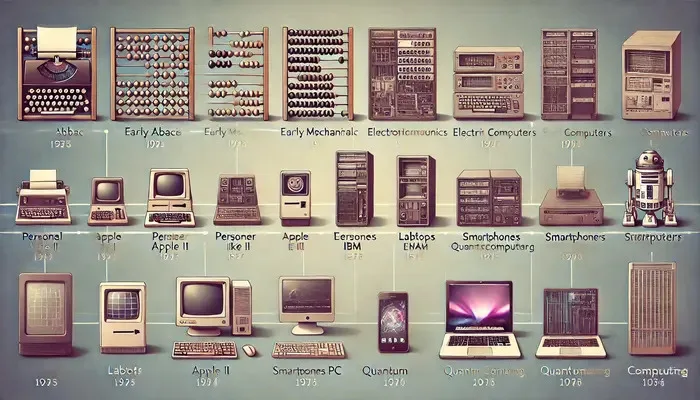

Evolución de la tecnología informática

La evolución de la tecnología informática ha sido un viaje marcado por hitos y avances tecnológicos notables. Desde la aparición de los dispositivos informáticos mecánicos hasta la llegada de la computación cuántica, esta evolución ha transformado la forma en que vivimos, trabajamos e interactuamos con el mundo. Este artículo profundiza en las etapas importantes de esta evolución, destacando los desarrollos clave y sus impactos.

Primeros pasos: dispositivos informáticos mecánicos

El viaje de la tecnología informática comenzó con dispositivos mecánicos diseñados para realizar operaciones aritméticas simples. Uno de los primeros dispositivos conocidos es el ábaco, utilizado durante siglos para ayudar en los cálculos. En el siglo XVII, Blaise Pascal inventó la Pascalina, una calculadora mecánica capaz de sumar y restar. Más tarde, en el siglo XIX, Charles Babbage conceptualizó la máquina analítica, un dispositivo más sofisticado que sentó las bases para las computadoras modernas. Aunque nunca se completó durante su vida, el diseño de Babbage incluía componentes como una unidad de control y memoria, fundamentales para las computadoras actuales.

Máquinas de computación electrónica (ECM)

Los albores del siglo XX vieron la transición de las máquinas informáticas mecánicas a las electrónicas. El desarrollo del tubo de vacío fue un momento crucial que condujo a la creación de las primeras computadoras electrónicas en la década de 1940. ENIAC (Electronic Numerical Integrator and Computer), desarrollado en 1945, fue uno de los primeros ordenadores digitales electrónicos de uso general. Era capaz de realizar cálculos complejos a velocidades sin precedentes. Esta era también vio la introducción del código binario, que se convirtió en la base de todas las operaciones informáticas posteriores.

Desarrollo de computadoras personales

La década de 1970 marcó un cambio significativo con el desarrollo de las computadoras personales (PC). Empresas como Apple e IBM revolucionaron la informática haciéndola accesible al público en general. El Apple II, lanzado en 1977, y el IBM PC, presentado en 1981, se convirtieron en nombres muy conocidos. Estas máquinas estaban impulsadas por microprocesadores, lo que redujo drásticamente el tamaño y el costo de las computadoras al tiempo que aumentaba su potencia y eficiencia. El desarrollo de sistemas operativos fáciles de usar, como MS-DOS de Microsoft y más tarde Windows, aceleró aún más la adopción de las PC.

La aparición de portátiles y ordenadores móviles

A medida que avanzaba la tecnología, el deseo de portabilidad llevó al desarrollo de computadoras portátiles y móviles. La primera computadora portátil comercialmente exitosa, la Osborne 1, se lanzó en 1981, aunque era voluminosa para los estándares actuales. Con el paso de los años, las computadoras portátiles se volvieron más compactas y potentes, y innovaciones como el panel táctil y la conectividad inalámbrica mejoraron su usabilidad. La década de 2000 vio el auge de los teléfonos inteligentes y las tabletas, que fusionaron la potencia informática con la movilidad y revolucionaron la forma en que accedemos a la información e interactuamos con ella mientras viajamos.

Internet y su impacto en la informática

La llegada de Internet a finales del siglo XX transformó fundamentalmente la informática. Inicialmente desarrollada como una red para uso académico y militar, Internet se expandió rápidamente hasta convertirse en una plataforma de comunicación global. La creación de la World Wide Web por Tim Berners-Lee en 1989 permitió un fácil acceso a la información y el desarrollo del comercio electrónico, las redes sociales y los servicios en línea. Internet también impulsó el crecimiento de la computación en la nube, que permite el almacenamiento y procesamiento de datos en servidores remotos, lo que se ha convertido en parte integral de la informática moderna.

Desarrollo de Software

Junto con los avances del hardware, el desarrollo de software ha desempeñado un papel crucial en la evolución de la tecnología informática. Los primeros programas a menudo se escribían a medida para máquinas específicas. Sin embargo, el desarrollo de lenguajes de programación como Fortran, COBOL y, posteriormente, C y Java, estandarizaron el desarrollo de software. El auge del software de código abierto, como Linux, fomentó la colaboración y la innovación. El software moderno abarca desde sistemas operativos y herramientas de productividad hasta aplicaciones complejas para inteligencia artificial y análisis de datos, llevando las capacidades del hardware a nuevas alturas.

Supercomputadoras y computación cuántica

La búsqueda de una mayor potencia computacional ha llevado al desarrollo de supercomputadoras y, más recientemente, a la computación cuántica. Las supercomputadoras, como las desarrolladas por Cray en la década de 1970, se utilizan para simulaciones y cálculos complejos en campos como la ciencia climática y la biología molecular. La computación cuántica, aún en sus etapas incipientes, promete revolucionar la informática aprovechando los principios de la mecánica cuántica. Las computadoras cuánticas tienen el potencial de resolver problemas que actualmente son intratables para las computadoras clásicas, abriendo nuevas fronteras en la ciencia y la tecnología.