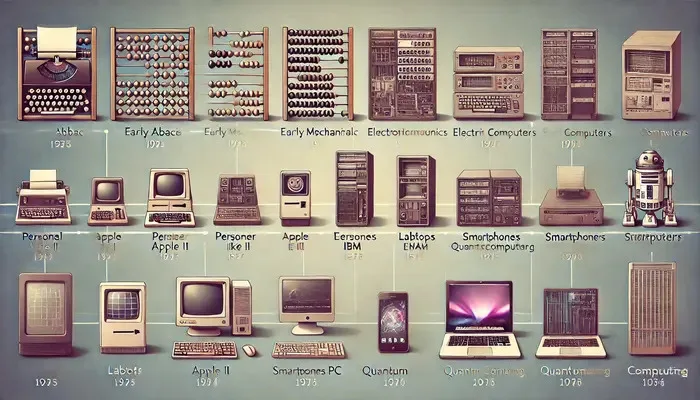

Entwicklung der Computertechnologie

Die Entwicklung der Computertechnologie war eine Reise, die von bemerkenswerten Meilensteinen und technologischen Durchbrüchen geprägt war. Von der Einführung mechanischer Rechengeräte bis zum Aufkommen des Quantencomputers hat diese Entwicklung unsere Lebens-, Arbeits- und Interaktionsweise mit der Welt verändert. Dieser Artikel befasst sich mit den wichtigsten Phasen dieser Entwicklung und hebt die wichtigsten Entwicklungen und ihre Auswirkungen hervor.

Erste Schritte: Mechanische Rechengeräte

Die Reise der Computertechnologie begann mit mechanischen Geräten, die für einfache Rechenoperationen entwickelt wurden. Eines der frühesten bekannten Geräte ist der Abakus, der jahrhundertelang als Rechenhilfe verwendet wurde. Im 17. Jahrhundert erfand Blaise Pascal die Pascaline, eine mechanische Rechenmaschine, mit der Addition und Subtraktion möglich waren. Später, im 19. Jahrhundert, konzipierte Charles Babbage die Analytical Engine, ein ausgefeilteres Gerät, das den Grundstein für moderne Computer legte. Obwohl Babbages Entwurf zu seinen Lebzeiten nie fertiggestellt wurde, enthielt er Komponenten wie eine Steuereinheit und einen Speicher, die für heutige Computer von grundlegender Bedeutung sind.

Elektronische Rechenmaschinen (ECMs)

Zu Beginn des 20. Jahrhunderts kam es zum Übergang von mechanischen zu elektronischen Rechenmaschinen. Die Entwicklung der Vakuumröhre war ein entscheidender Moment, der in den 1940er Jahren zur Entwicklung der ersten elektronischen Computer führte. Der 1945 entwickelte ENIAC (Electronic Numerical Integrator and Computer) war einer der ersten universellen elektronischen Digitalcomputer. Er war in der Lage, komplexe Berechnungen mit beispielloser Geschwindigkeit durchzuführen. In dieser Ära wurde auch der Binärcode eingeführt, der zur Grundlage aller nachfolgenden Computeroperationen wurde.

Entwicklung von Personalcomputern

Die 1970er Jahre markierten mit der Entwicklung von Personalcomputern (PCs) einen bedeutenden Wandel. Unternehmen wie Apple und IBM revolutionierten die Computertechnik, indem sie sie der breiten Öffentlichkeit zugänglich machten. Der 1977 veröffentlichte Apple II und der 1981 eingeführte IBM PC wurden zu allgemein bekannten Namen. Diese Maschinen wurden von Mikroprozessoren angetrieben, die die Größe und die Kosten der Computer drastisch reduzierten und gleichzeitig ihre Leistung und Effizienz erhöhten. Die Entwicklung benutzerfreundlicher Betriebssysteme wie MS-DOS und später Windows von Microsoft beschleunigte die Verbreitung von PCs zusätzlich.

Die Entstehung von Laptops und mobilen Computern

Mit dem technologischen Fortschritt führte der Wunsch nach Mobilität zur Entwicklung von Laptops und mobilen Computern. Der erste kommerziell erfolgreiche Laptop, der Osborne 1, kam 1981 auf den Markt, war jedoch nach heutigen Maßstäben ziemlich sperrig. Im Laufe der Jahre wurden Laptops kompakter und leistungsfähiger, und Innovationen wie das Touchpad und die drahtlose Konnektivität verbesserten ihre Benutzerfreundlichkeit. In den 2000er Jahren kamen Smartphones und Tablets auf, die Rechenleistung mit Mobilität verbanden und die Art und Weise revolutionierten, wie wir unterwegs auf Informationen zugreifen und mit ihnen interagieren.

Das Internet und seine Auswirkungen auf die Computertechnik

Die Einführung des Internets im späten 20. Jahrhundert veränderte die Computertechnik grundlegend. Ursprünglich als Netzwerk für akademische und militärische Zwecke entwickelt, entwickelte sich das Internet schnell zu einer globalen Kommunikationsplattform. Die Erfindung des World Wide Web durch Tim Berners-Lee im Jahr 1989 ermöglichte einen einfachen Zugang zu Informationen und die Entwicklung von E-Commerce, sozialen Medien und Online-Diensten. Das Internet trieb auch das Wachstum des Cloud-Computing voran und ermöglichte die Speicherung und Verarbeitung von Daten auf Remote-Servern, was zu einem integralen Bestandteil der modernen Computertechnik geworden ist.

Entwicklung von Software

Neben Hardware-Fortschritten hat die Software-Entwicklung eine entscheidende Rolle bei der Entwicklung der Computertechnologie gespielt. Frühe Software wurde oft speziell für bestimmte Maschinen geschrieben. Die Entwicklung von Programmiersprachen wie Fortran, COBOL und später C und Java standardisierte jedoch die Softwareentwicklung. Der Aufstieg von Open-Source-Software wie Linux förderte Zusammenarbeit und Innovation. Moderne Software reicht von Betriebssystemen und Produktivitätstools bis hin zu komplexen Anwendungen für künstliche Intelligenz und Datenanalyse und treibt die Fähigkeiten der Hardware auf ein neues Niveau.

Supercomputer und Quantencomputing

Das Streben nach mehr Rechenleistung hat zur Entwicklung von Supercomputern und in jüngerer Zeit zum Quantencomputing geführt. Supercomputer, wie sie Cray in den 1970er Jahren entwickelte, werden für komplexe Simulationen und Berechnungen in Bereichen wie der Klimawissenschaft und der Molekularbiologie eingesetzt. Das Quantencomputing, das sich noch in den Kinderschuhen befindet, verspricht, die Computertechnik zu revolutionieren, indem es die Prinzipien der Quantenmechanik nutzt. Quantencomputer haben das Potenzial, Probleme zu lösen, die für klassische Computer derzeit unlösbar sind, und eröffnen so neue Grenzen in Wissenschaft und Technologie.